Automatische Generierung von Lead-Informationen im Bereich der Schwermaschinenindustrie

Zusammenfassung

Das Kundenbeziehungsmanagement in der Schwerindustrie zeichnet sich durch große Kundendatenbanken aus, in denen manchmal wichtige Informationen fehlen, wie z. B. der Geschäftsbereich, in dem der Kunde tätig ist. Die Gewinnung neuer wichtiger Kundeninformationen ist für einen erfolgreichen Verkaufsprozess unerlässlich. Die manuelle Suche nach diesen Informationen ist mühsam und erfordert viele Arbeitsstunden.

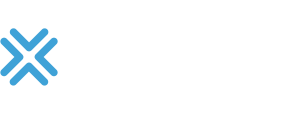

brox IT-solutions ist diese Herausforderung mit einer auf Knowledge-Graphen basierenden Lösung angegangen, die untersucht, ob ein Unternehmen potenzielle Verbindungen zu einem bestimmten Geschäftsbereich hat. Anhand dieser Informationen können potenzielle Kunden priorisiert und ermittelt werden. So kann mehr Umsatz erzielt werden, indem schneller Leads generiert und die Kosten gesenkt werden, weil weniger manuelle Arbeit für die Bearbeitung von Leads erforderlich ist.

Zielsetzung

Ein Unternehmen aus der Schwermaschinenindustrie wollte seine bestehenden CRM-Daten mit Informationen über Geschäftsbereiche anreichern. Um dies zu erreichen, wurde ein Lead-Repository mit den folgenden Eigenschaften gewünscht:

- Das Repository enthält Daten über den potenziellen Kunden, die auf der Website des Unternehmens verfügbar sind.

- Es unterstützt das Auffinden von Leads oder Informationen, die dem Vertriebsteam helfen können, ein besseres Verkaufsgespräch entsprechend den Anforderungen des Kunden zu führen.

Ein weiterer Faktor ist die Umwandlung der verfügbaren Daten in aussagekräftige Informationen, die wiederum Folgendes ermöglichen:

- Eine gezielte Ansprache des Kunden und

- das Auffinden von Bereichen, die für den potenziellen Kunden von Interesse sind

Herausforderungen

Bei diesem Problem sind drei wesentliche Herausforderungen zu erkennen:

- Extrahieren der Daten: Da das Scraping von Webdaten mit „Noise“ (Rauschen) oder unerwünschten Daten einhergeht, ist ein Ansatz erforderlich, der dieses Rauschen reduziert und die Daten bereinigt. Die Bereinigung der Daten bringt die zusätzliche Herausforderung mit sich, nicht versehentlich wichtige Informationen zu entfernen. Es ist also ein Prozess erforderlich, der nicht nur das Rauschen reduziert, sondern auch ein Maximum an verwertbaren Daten aus dem gesammelten Text erhält.

- Verschiedene Unternehmen verwenden unterschiedliche Begriffe zur Beschreibung ihres Geschäftsbereichs, die einander ähnlich sein können. Dies würde einen Fachmann fordern, der ähnliche Begriffe in seinem Bereich identifiziert, was viele Arbeitsstunden erfordern würde.

- Umwandlung der Daten in sinnvolle Informationen: Sobald die Daten verarbeitbar sind, besteht der nächste Schritt darin, sie in Informationen umzuwandeln. Bei der Generierung von Informationen liegt der Schwerpunkt darauf, wie die Daten präsentiert werden und wie sie aussagekräftig gemacht werden können. Die Herausforderung besteht also darin, eine Methode zu finden, die nicht nur die Daten verwertbar macht, sondern auch den notwendigen Kontext liefert, um die Informationen verständlich zu machen.

Lösung

Die erste Herausforderung bestand darin, öffentlich verfügbare Daten zu erhalten. Zu diesem Zweck wurde ein Web-Crawler (Beautiful Soup, Scrapy) auf die Ziel-Website angewendet, um eine Reihe von Texten von der Website zu generieren. Der extrahierte Text musste in verwertbare Informationen umgewandelt werden.

Um herauszufinden, welche Begriffe aus dem extrahierten Text mit dem gewünschten Bereich in Verbindung stehen, wurden folgende Schritte durchgeführt:

- Extrahieren von Schlüsselwörtern aus dem Text und Anhängen von Metadaten, was über Wikifier.org geschieht, dass die Websites mit dbpedia.org verknüpft, um die Daten anzureichern.

- Erstellung eines Graphen unter Verwendung der angereicherten Daten und Speicherung in einem Knowledge-Graph -Repository (GraphDB, AllegroGraph).

Wenn ein Unternehmen in einem bestimmten Bereich tätig ist, werden in den extrahierten Daten wiederholt bereichsbezogene Begriffe erwähnt. Daher wurden die folgenden Schritte unternommen, um dieses Ziel zu erreichen:

- Eine SPARQL-Abfrage wurde verwendet, um die Informationen im Graphen zu untersuchen.

- Die Abfrage sucht nach Entitäten, die in direktem oder entferntem Zusammenhang mit der relevanten Domäne stehen.

Das Ergebnis der Abfrage wurde verwendet, um festzustellen, wie stark ein Unternehmen mit einer Domäne verbunden ist.

Geschäftsvorteile

Die Implementierung dieser Lösung bringt der Branche einige entscheidende Vorteile:

- Automatische Extraktion von Geschäftsbereichsinformationen – kein manuelles Durchsuchen von Kundenwebsites erforderlich, was zu Kosteneinsparungen führt.

- Die Informationen liefern potenzielle Anhaltspunkte dafür, ob der betreffende Kunde in einem bestimmten Bereich tätig ist, was einen maßgeschneiderten Ansatz ermöglicht, der den Umsatz steigern kann.

- Die Lösung hilft bei der Einrichtung eines auf Prioritäten basierenden Ansatzes innerhalb der Liste der potenziellen Kunden. Dadurch werden die Verkäufe auf die richtigen Kunden fokussiert, was zu einer Steigerung des Umsatzes führt.

- Die Informationen können in mehreren Bereichen genutzt werden, so dass die meisten Kunden mit unterschiedlichen Zielen angesprochen werden können.

- Da der extrahierte Text und DBpedia öffentliche Domänen sind, fallen keine Kosten für den Zugriff auf die Daten an, was die Kosten im Vergleich zum Kauf von kuratierten Leads senkt.